La Red Martinez, David L., Acosta, Julio, Cutro, Alfonso, Uribe, Valeria E., Rambo, Alice R.

RESUMEN

El relativamente bajo % de alumnos promocionados y regularizados (éxito académico) en Sistemas Operativos de la Licenciatura en Sistemas de Información (LSI) de la Facultad de Ciencias Exactas y Naturales y Agrimensura (FACENA) de la Universidad Nacional del Nordeste (UNNE), motivó un proyecto de investigación del cual este trabajo es una pequeña parte, cuyo objetivo es determinar las variables que inciden en el rendimiento académico, considerando la situación final del alumno según la Res. N° 185/03 CD (régimen de evaluación y promoción): promocionado, regular o libre. Las variables consideradas son: situación del alumno, nivel educacional de los padres, educación secundaria, nivel socio-económico, edad, género, si trabaja y la actitud hacia el estudio y las TICs. En este trabajo se considera especialmente el aspecto relacionado con las TICs. Se utilizaron técnicas de Almacén de Datos (Data Warehouses: DW) y de Minería de Datos (Data Mining: DM), para buscar perfiles de los alumnos y determinar situaciones de éxito o de fracaso académico.

Palabras Claves: TICs, Almacén de Datos, Minería de Datos, Clustering, Cluster Demográfico, Rendimiento Académico, Perfiles de Alumnos, Sistemas Operativos.

ABSTRACT

The relatively low % of students promoted and regularized (academic success) in Operating Systems Cathedra of the Bachelor's Degree in Information Systems (LSI) of the Faculty of Sciences and Natural Surveying (FACENA) of the Northeast National University (UNNE), has motivated an project research which this work is a small part, whose objective is to determine the variables that affect the academic performance, whereas the final status of the student according to the Res. 185/03 CD (scheme for evaluation and promotion): promoted, regular or free [1]. The variables considered are: status of the student, educational level of parents, secondary education, social and economic level, age, nature, if it works and the attitude towards study and ICTs.This work especially considers ICT aspect. Data Warehouse (DW) and Data Mining (DM) techniques were used, to search for profiles of the students and identify situations of success or failure academic.

Keywords: ICTs, Data Warehouse, Data Mining, Clustering, Demographic Cluster, Academic Performance, Student’s Profiles, Operating Systems.

1. INTRODUCCIÓN

Tomando como referencia la información oficial de la UNNE [2], la carrera de Sistemas de la FACENA ha registrado una matrícula considerable de alumnos de la UNNE (2005: 4,42%; 2006: 3,93%; 2007: 3,82%; 2008: 3,53%; 2009: 3,34% (aspirantes); 2010: 2,79% (aspirantes)); ha sido la carrera de mayor número de alumnos en la FACENA (2005: 37,64%; 2006: 34,77%; 2007: 33,23%; 2008: 30,32%; 2009: 26,47% (aspirantes); 2010: 24,80% (aspirantes)), la de mayor cantidad de nuevos inscriptos en la FACENA (2005: 33,92%; 2006: 29,89%; 2007: 29,71%; 2008: 38,74%; 2009: 23,70%; 2010: 23,30%) y la que más egresados ha producido en la FACENA (2004: 56,05%; 2005: 41,99%; 2006: 44,02%; 2007: 54,30%; 2008: 46,63%). Estos datos demuestran de manera elocuente la importancia de la carrera de Sistemas (Licenciatura en Sistemas de Información: LSI) de la FACENA de la UNNE.

Un análisis más detallado permite observar los relativamente bajos porcentajes de egresados respecto de nuevos inscriptos en la LSI; estos porcentajes varían si se considera solamente el título terminal de grado (Licenciado en Sistemas de Información) o si además se considera el título intermedio (Programador Universitario de Aplicaciones):

- Sin considerar el título intermedio: 2005: 4,81%, 2006: 5,27%, 2007: 9,49%, 2008: 5,42%.

- Considerando el título intermedio: 2005: 21,81%, 2006: 20,22%, 2007: 18,98%, 2008: 15,51%.

Estos porcentajes relativamente bajos en la relación egresados respecto de nuevos inscriptos se observan también considerando a la FACENA y a la UNNE en su totalidad:

- FACENA: 2005: 17,62%, 2006: 13,73%, 2007: 10,39%, 2008: 12,89%.

- UNNE: 2005: 22,57%, 2006: 22,11%, 2007: 20,49%, 2008: 22,36%.

Lo señalado en los párrafos precedentes permite afirmar que la relación entre egresados y nuevos inscriptos es en general relativamente baja, y especialmente baja si se considera a la LSI sin los egresados con título intermedio.

Las relativamente bajas tasas de egresados respecto de nuevos inscriptos mencionadas en el apartado anterior, que podríamos considerar el “rendimiento académico global” de una Carrera, Facultad o Universidad, se observan también en numerosas asignaturas de la LSI, considerando “rendimiento académico particular” o simplemente “rendimiento académico”, a los resultados de las evaluaciones de los alumnos durante el cursado de una asignatura, y la condición final lograda por los mismos en el marco de la Res. N° 185/03 CD (régimen de evaluación y promoción): promocionado, regular o libre.

Para la asignatura Sistemas Operativos los valores de los últimos años son los siguientes:

- Alumnos promocionados y regularizados respecto de los que rindieron algún examen parcial: 2006: 21,05%, 2007: 32,89%, 2008: 34,86%, 2009: 13,51%.

Además se ha observado que un considerable porcentaje de alumnos se inscriben para cursar la asignatura, pero luego de realizar alguna actividad abandonan el cursado (45,45% en el 2009), o se inscriben para cursar y no cursan, es decir no realizan actividad alguna (29,19% en el 2009).

Asimismo, reiteradamente se ha observado una escasa concurrencia de los alumnos a las tutorías establecidas para brindarles apoyo en la realización de las diferentes actividades planificadas (teorías, prácticos, laboratorios).

Ante la situación mencionada se consideró de gran importancia efectuar una investigación que permita determinar las variables que inciden en el relativamente bajo rendimiento académico de los alumnos de Sistemas Operativos de la LSI de la FACENA de la UNNE, identificar los perfiles de alumnos exitosos (los que promocionan o regularizan la asignatura), como así también los perfiles de alumnos que no lo logran (los que quedan en la condición de libres).Una vez determinados los perfiles de alumnos con bajo rendimiento académico, se podrán encarar acciones tendientes a evitar potenciales fracasos académicos. Para la determinación de los perfiles de alumnos se consideró apropiado utilizar técnicas de DW y DM.

Este artículo se ha estructurado de la siguiente manera: primeramente se planteará el objetivo principal del mismo, luego se hará una muy breve revisión de los principales conceptos involucrados en cuanto a DW y DM, seguidamente se indicará brevemente el software utilizado, para continuar con la metodología seguida y la presentación de algunos resultados obtenidos relacionados con las TICs, para finalizar con las conclusiones y líneas futuras de acción, los reconocimientos y las referencias.

2. OBJETIVO PRINCIPAL

El objetivo principal de este trabajo es encontrar perfiles de alumnos por medio de la aplicación de técnicas de DM a un DW con datos académicos, socio económicos y demográficos correspondientes a alumnos de SO de la Licenciatura en Sistemas de Información (LSI) de la FACENA de la UNNE, especialmente desde la perspectiva que de las TICs tienen los alumnos.

3. REVISIÓN CONCEPTUAL

Un DW es una colección de datos orientado a temas, integrado, no volátil, de tiempo variante, que se usa para el soporte del proceso de toma de decisiones gerenciales (Kubski, 2005), (Cutro, 2008). Es también un conjunto de datos integrados orientados a una materia, que varían con el tiempo, y que no son transitorios, los cuales soportan el proceso de toma de decisiones de una administración (Inmon, 1992), (Inmon, 1996), (Simon, 1997), (Trujillo, Palomar & Gómez, 2000).

La DM es la etapa de descubrimiento en el proceso de KDD (Knowledge Discovery from Databases), es el paso consistente en el uso de algoritmos concretos que generan una enumeración de patrones a partir de los datos preprocesados (Fayyad, Grinstein & Wierse, 2001), (Fayyad, Piatetskiy-Shapiro, Smith, & Ramasasmy, 1996), (Han & Kamber, 2001), (Hand, Mannila & Smyth, 2000).

Es también un mecanismo de explotación, consistente en la búsqueda de información valiosa en grandes volúmenes de datos. Está muy ligada a los DW ya que los mismos proporcionan la información histórica con la cual los algoritmos de minería obtienen la información necesaria para la toma de decisiones (Gutiérrez, 2001), (IBM Software Group, 2003).

La DM es un conjunto de técnica de análisis de datos que permiten extraer patrones, tendencias y regularidades para describir y comprender mejor los datos y extraer patrones y tendencias para predecir comportamientos futuros (Simon, 1997), (Berson & Smith, 1997), (Frawley, Piatetsky-Shapiro & Matheus, 1992), (White, 2001).

4. SOFTWARE UTILIZADO

Se ha utilizado el IBM Data Warehouse Edition (DWE) V.9.5, que incluye al DB2 Enterprise Server Edition (DB2 ESE), al Design Studio (DS) y al Intelligent Miner (IM), que se han obtenido de la empresa IBM Argentina S.A. en el marco de la Iniciativa Académica de dicha empresa y de los Acuerdos realizados entre la misma y la FACENA de la UNNE (Acuerdo del 18/06/04 D, Res. N° 1417/04 D, Res. N° 858/06 CD).

5. METODOLOGÍA SEGUIDA

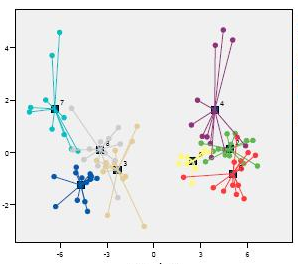

El presente estudio se realizó sobre datos obtenidos mediante encuestas realizadas al alumnado de SO, considerando además los resultados de las distintas instancias de evaluación previstas durante el cursado de dicha asignatura. Se utilizó un entorno integrado de gestión de bases de datos y data warehouse (DB2 versión 9.5), obtenido de la empresa IBM mediante los Acuerdos firmados entre dicha empresa y la UNNE; dicho entorno permite la extracción de conocimiento en bases de datos y DW mediante técnicas de DM como ser clustering (o agrupamiento de datos) que consiste en la partición de un conjunto de individuos en subconjuntos lo más homogéneos posible, el objetivo es maximizar la similitud de los individuos del cluster y maximizar la diferencia entre clusters. El cluster demográfico es un algoritmo desarrollado por IBM e implementado en el IM, componente del DWE, entorno antes mencionado, que resuelve automáticamente los problemas de definición de métricas de distancia / similitud, proporcionando criterios para definir una segmentación óptima (Grabmeier, & Rudolph, 1998), (Baragoin, Chan, Gottschalk, Meyer, Pereira & Verhees, 2002), (Ballard, Rollins, Ramos, Perkins, Hale, Dorneich, Cas Milner & Chodagam, 2007), Ballard, Beaton, Chiou, Chodagam, Lowry, Perkins, Phillips & Rollins, 2006).

Los pasos realizados durante el presente trabajo han sido los siguientes:

- Recolección de los datos.

- Tratamiento y depuración de los datos.

- Preparación de la base de datos y del DW correspondiente sobre la plataforma de trabajo seleccionada.

- Selección de la técnica de minería de datos para la realización del estudio (predominantemente clustering).

- Generación de diferentes gráficos para el estudio de los resultados.

- Estudio de los resultados obtenidos.

- Obtención de las conclusiones.

En esta etapa se trabajó con una porción (Data Mart: DMa) del DW, cuya estructura se muestra en la figura 1.

6. RESULTADOS OBTENIDOS

Se obtuvieron diferentes clasificaciones mediante la utilización (preferentemente) de técnicas de clustering, según diferentes criterios de agrupación de los datos.

Se utilizó la tabla 1 de nombres y significados de variables.

Seguidamente se muestran algunos de los resultados obtenidos, especialmente en relación con la percepción que de las TICs tienen los alumnos, pregunta a la cual no respondió el 60% de los alumnos, el 20% contestó que facilitan el proceso de enseñanza – aprendizaje, el 12 % consideró que será imprescindible su dominio, y el 8% expresó que son una realidad.

En la figura 2 se muestra la razón para estudiar manifestada por quienes no respondieron la pregunta relativa a la importancia de las TICs. Se observa que el 83% de este grupo no contestó la pregunta referida a la razón para estudiar; el 10% manifestó que estudia para aprender integralmente y el 6% que lo hace para aprender a aprender.

![]()

Figura 1: Estructura del DMa utilizado, parte del DW.

En la figura 3 se muestra el estado civil de quienes no respondieron la pregunta relativa a la importancia de las TICs. Se observa que el 98% de este grupo son solteros y el 2% casados.

![]()

Figura 2: Razón para estudiar.

En la figura 4 se muestra la importancia concedida al estudio manifestada por quienes no respondieron la pregunta relativa a la importancia de las TICs. Se observa que el 83% de este grupo no contestó la pregunta referida a la importancia de estudiar; el 14% manifestó que concede al estudio más importancia que a la diversión y el 3% que considera al estudio más importante que al trabajo.

En la figura 5 se muestra la situación final del alumno lograda por quienes no respondieron la pregunta relativa a la importancia de las TICs. Se observa que el 48% de este grupo al final del cursado quedó en condición de “libre”; el 29% logró la condición de “regular” y el 23% “promocionó” la asignatura.

En la figura 6 se muestra la razón para estudiar manifestada por quienes consideran que las TICs facilitan el proceso de enseñanza - aprendizaje. Se observa que el 56% de este grupo expresó que la razón para estudiar es aprender integralmente; el 21% manifestó que estudia para aprender a aprender y el 21% que lo hace para aprobar.

En la figura 7 se muestra el estado civil de quienes consideran que las TICs facilitan el proceso de enseñanza - aprendizaje. Se observa que el 91% de este grupo son solteros, el 6% casados y el 3% se encuentra en unión consensual.

![]()

Figura 3: Estado civil.

![]()

Figura 4: Importancia concedida al estudio.

En la figura 9 se muestra la situación final del alumno lograda por quienes consideran que las TICs facilitan el proceso de enseñanza - aprendizaje. Se observa que el 70% de este grupo al final del cursado quedó en condición de “libre”; el 15% logró la condición de “regular” y el 15% “promocionó” la asignatura.

![]()

Figura 5: Situación final del alumno.

![]()

Figura 6: Razón para estudiar.

En la figura 10 se muestra la razón para estudiar manifestada por quienes consideran que será imprescindible el dominio de las TICs. Se observa que el 48% de este grupo expresó que la razón para estudiar es aprender integralmente; el 42% manifestó que estudia para aprender a aprender y el 5% que lo hace para aprobar.

![]()

Figura 7: Estado civil.

![]()

Figura 8: Importancia concedida al estudio.

![]()

Figura 9: Situación final del alumno.

![]()

Figura 10: Razón para estudiar.

En la figura 11 se muestra el estado civil de quienes consideran que será imprescindible el dominio de las TICs. Se observa que el 90% de este grupo son solteros y el 10% casados.

En la figura 12 se muestra la importancia concedida al estudio manifestada por quienes consideran que será imprescindible el dominio de las TICs. Se observa que el 71% de este grupo manifestó que concede al estudio más importancia que a la diversión, el 24% que considera al estudio más importante que al trabajo y el 5% que considera al estudio más importante que a la familia.

![]()

Figura 11: Estado civil.

En la figura 14 se muestra la razón para estudiar manifestada por quienes consideran que las TICs son una realidad. Se observa que el 69% de este grupo expresó que la razón para estudiar es aprender integralmente y el 31% manifestó que estudia para aprender a aprender.

En la figura 15 se muestra el estado civil de quienes consideran que las TICs son una realidad. Se observa que el 92% de este grupo son solteros y el 8% divorciados legalmente.

En la figura 16 se muestra la importancia concedida al estudio manifestada por quienes consideran que las TICs son una realidad. Se observa que el 62% de este grupo manifestó que concede al estudio más importancia que a la diversión, el 23% que considera al estudio más importante que al trabajo y el 8% que considera al estudio más importante que a la familia.

![]()

Figura 12: Importancia concedida al estudio.

![]()

Figura 13: Situación final del alumno.

En la figura 17 se muestra la situación final del alumno lograda por quienes consideran que las TICs son una realidad. Se observa que el 62% de este grupo al final del cursado quedó en condición de “libre”; el 23% logró la condición de “regular” y el 15% “promocionó” la asignatura.

![]()

Figura 14: Razón para estudiar.

![]()

Figura 15: Estado civil.

![]()

Figura 16: Importancia concedida al estudio.

![]()

Figura 17: Situación final del alumno.

7. CONCLUSIONES Y LÍNEAS FUTURAS

Se ha podido comprobar las grandes ventajas de la utilización de tecnologías y software de última generación que soportan sistemas multiplataforma.

Se hace notar que los resultados mostrados corresponden a sólo una parte de la etapa preliminar de los diversos estudios que se están realizando.

Se destaca que los mayores porcentajes de “éxito académico” (regularizados + promocionados) corresponden a las siguientes categorías respecto de la opinión acerca de las TICs: no contestaron (52% de éxito académico), consideran que las TICs son una realidad (38% de éxito académico), consideran que es imprescindible el dominio de las TICs (34% de éxito académico), consideran que las TICs facilitan el proceso de enseñanza – aprendizaje (30% de éxito académico).

Se tiene previsto desarrollar las siguientes líneas futuras de acción:

- Avanzar en la investigación con la utilización de minería de datos como ser redes neuronales, redes bayesianas, arboles de decisión, etc., aplicadas al almacén de datos utilizado hasta ahora generalmente con las técnicas de clustering.

- Aplicar las técnicas de minería de datos utilizadas, pero sobre otras bases de datos de alumnos de otras asignaturas y carreras para comparar los resultados obtenidos.

8. RECONOCIMIENTOS

El presente trabajo se encuadra en el Proyecto de Investigación “El Desigual Aprovechamiento de las TICs en el Proceso de Enseñanza – Aprendizaje de los Sistemas Operativos en la FACENA de la UNNE”, acreditado por la Secretaría de Ciencia y Técnica de la UNNE como PI-120-07 (Res. N° 369/08 CS).

9. REFERENCIAS

Ballard, Ch.; Beaton, A.; Chiou, D.; Chodagam, J.; Lowry, M.; Perkins, A.; Phillips, R. & Rollins, J. (2006). Leveraging DB2 Data Warehouse Edition for Business Intelligence. IBM International Technical Support Organization. IBM Press. USA.

Ballard, Ch.; Rollins, J.; Ramos, J.; Perkins, A.; Hale, R.; Dorneich, A.; Cas Milner, E. & Chodagam, J. (2007). Dynamic Warehousing: Data Mining Made Easy. IBM International Technical Support Organization. IBM Press. USA.

Baragoin, C.; Chan, R.; Gottschalk, H.; Meyer, G.; Pereira, P. & Verhees, J. (2002). IBM International Technical Support Organization Enhance Your Business Applications. Simple Integration of Advanced Data Mining Functions. IBM Press.

Berson, A. & Smith, S. J. (1997). Data Warehouse, Data Mining & OLAP. Mc Graw Hill. USA.

Bolaños Calvo, B. (2001). Las Nuevas Tecnologías y los Desafíos Teórico – Prácticos en los Sistemas de Educación a Distancia: Caso UNED de Costa Rica. Temática: Universidades Virtuales y Centros de Educación a Distancia. UNED. Costa Rica.

Cutro, A. (2008). Minería de Datos Aplicada a la Encuesta Permanente de Hogares. Trabajo Final de Aplicación de la Licenciatura en Sistemas de Información dirigido por el Prof. David Luis la Red Martínez.Corrientes. Argentina.

Fayyad, U.M.; Grinstein, G. & Wierse, A. (2001). Information Visualization in Data Mining and Knowledge Discovery. Morgan Kaufmann. Harcourt Intl.

Fayyad, U.M.; Piatetskiy-Shapiro, G.; Smith, P.; Ramasasmy, U. (1996). Advances in Knowledge Discovery and Data Mining. AAAI Press / MIT Press. USA.

Frawley, W. J.; Piatetsky-Shapiro, G & Matheus, Ch. J. (1992). Knowledge Discovery in Database An Overview. Al Magazine.

Grabmeier, J. & Rudolph, A. (1998). Techniques of Cluster Algorithms in Data Mining version 2.0. IBM Deutschland Informationssysteme GmbH. GBIS (Global Business Intelligence Solutions). Germany.

Gutiérrez, J. M. (2001). Data Mining, Extracción de Conocimiento en Grandes Bases de Datos. España.

Han, J. & Kamber, M. (2001). Data Mining: Concepts and Techniques. Morgan Kaufmann.

Hand, D.J.; Mannila, H. & Smyth, P. (2000). Principles of Data Mining. The MIT Press. USA.

IBM Software Group. (2003). Enterprise Data Warehousing whit DB2: The 10 Terabyte TPC-H Benchmark. IBM Press. USA.

Inmon, W. H. (1992). Data Warehouse Performance. John Wiley & Sons. USA.

Inmon, W. H. (1996). Building the Data Warehouse. John Wiley & Sons. USA.

Joyanes Aguilar, L. (1997). Cibersociedad. Mc Graw Hill. España.

Kubski, M. (2005). Aplicación Orientada al Descubrimiento de Conocimiento en Bases de Datos. Trabajo Final de Aplicación de la Licenciatura en Sistemas de Información dirigido por el Prof. David Luis la Red Martínez. Corrientes. Argentina.

Peiró, J. M. (2001). Las competencias en la sociedad de la información: nuevos modelos formativos.Centro Virtual Cervantes. España.

Simon, A. (1997). Data Warehouse, Data Mining and OLAP. John Wiley & Sons. USA.

Taquini, A. C. (h). (2001). Educación Superior y Ciberespacio.

Trujillo, J. C., Palomar M. & Gómez, J. (2000). Applying Object-Oriented Conceptual Modeling Techniques To The Design of Multidimensional Databases and OLAP Applications. First International Conference On Web-Age Information Management (WAIM’00). Lecture Notes in Computer Science 1846:83-94.

[1]“Promoted” refers to students that to be exempt from the final exam. “Regularized” Refers to students that approve the partial examinations; they test theoretical concepts in the final exam. A student is "Free" when he reproves the partial examinations and he should make again the course or must to test out of the course.

[2] Fuente: Secretaría General Académica UNNE: http://www.unne.edu.ar/institucional/, última consulta: 15/07/10.

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)